以下は、コンピュータワールド社のWebからの引用である。

情報化投資最適化請負人として、企業や団体のIT投資の最適化のために支援していることが端的に開設されていると思って引用した。

データセンターの大きな使命のひとつは、「安全安定運用」である。この安全安定運用を疎外する要因の大きなものが、アプリケーション・システムの複雑さだといわれている。現状を俯瞰し、複雑さを排除することで、身の丈の「低価格」で「安全安定」なデータセンターを運営することができる。

株式会社アーバーズのサービス

1.IT投資の現状俯瞰

2.ITコストの最適化

3.複雑化したIT資産の最適化

複雑さを増すデータセンター、いかにして対処するべきか

複雑さの要因とは何か、またそれが引き起こす影響とは

(2012年09月28日)

http://www.computerworld.jp/topics/603/205008

データセンターの複雑さは、コストの増加、俊敏性の低下、ひいてはダウンタイムなど、数々の好ましくない影響を企業に与える。データセンター20+ 件の複雑さを本気で軽減しようとするならば、トレーニング、標準化、そして情報ガバナンスが不可欠なのだ。データセンターの複雑さを軽減するためのベスト・プラクティスを紹介する。

Thor Olavsrud/CIO米国版

データセンターの複雑さは、コストの増加、俊敏性の低下、ひいてはダウンタイムなど、数々の好ましくない影響を企業に与える。この5年間で、組織はデータセンターを仮想化することで、複雑さを軽減し効率を上げようと努めてきた。仮想化には確かに利点がある。とはいえ、そのようなプロジェクトの多くはデータセンターの複雑さをなくすというよりも、変化させているといえる。データセンターの複雑さを本気で軽減しようとするならば、トレーニング、標準化、そして情報ガバナンスが不可欠なのだ。

「かなり多くの人が、仮想化はデータセンターにとってのペニシリンであると思っている。しかし、われわれが見たところでは、人々は仮想化に大きな投資をしている一方で、仮想化の効果を迅速に認識する洞察力を必ずしも持っていないことがある」と、米国Symantecの製品マーケティング担当ディレクター、ダニー・ミルラッド(Danny Milrad)氏は述べている。同社は先般、「2012 State of the Data Center Survey(2012年のデータセンター実態調査)」の結果を発表した。「仮想化の利点の1つは、アプリケーションの展開を非常に速くすることだが、人々はそのアプリケーションで必要なフットプリントがどれほど大きくなるかについては考えない」(ミルラッド氏)

データセンターの複雑さの要因となるビジネス・クリティカル・アプリケーション

ビジネス・クリティカル・アプリケーションの数が増加していることは、データセンター20+ 件の複雑さを助長する大きな原因となっている。Symantecの調査では、回答者の65%がこの増加をデータセンターが複雑になる原因として挙げた。Symantecは32か国2,453人のITプロフェッショナルを調査。回答者には、オペレーションと戦術的機能を担当する上級ITスタッフや、プランニングおよびITマネジメントを担当するスタッフが含まれていた。

「ファイルと印刷に関するもの以外で、ビジネス・クリティカル・アプリケーションではない最近のアプリケーションを見せてほしい。アプリケーションを複製することになれば、ストレージの使用量が増える。オンラインで提供される新しいアプリケーションは仮想化が進んでおり、予想よりはるかに多い量のデータが発生する」とミルラッド氏は言う。

そのような事態になれば、組織は壁にぶつかってしまう。「仮想化が進めば進むほど、ストレージのコストと仮想化のためのライセンスに関わるコスト、そして関連して発生するあらゆるものが、予想よりも速いスピードで増えていく。ストレージが安価であっても、予想の10倍も購入しなければならないとすれば、相当高くつくことになる」(ミルラッド氏)

データセンター20+ 件の複雑さを助長しているほかの大きな要素としては、モバイル・コンピューティング(回答者の44%が指摘)、サーバの仮想化(43%)、パブリック・クラウド(41%)などがあり、戦略的なITトレンドが広がっている。データセンター20+ 件の複雑さの影響として最も多く挙げられたのはコストの増加(47%)だったが、ほかにも俊敏性の低下(39%)、ストレージ移行にかかる時間の増加(39%)、ストレージのプロビジョニング(38%)、セキュリティ違反(35%)、ダウンタイム(35%)が挙げられた。

複雑さ:データセンター停止の大きな原因

この調査によって、一般的な組織が過去12か月の間に平均16回のデータセンター停止を経験していることが分かった。かかったコストの総額は510万ドルに達した。全体を見ると、自然災害が原因であるものが1回(コスト150万ドル)、人的エラーが4回(コスト170万ドル)、複雑さによるシステム障害が11回(コスト190万ドル)だった。

仮想化が悪いということではないが、IT部門は注意深くあり、悪影響の可能性についても準備をしておくべきだ、とミルラッド氏は慎重に指摘する。

「これはSharePoint導入の際に起きたこととよく似ている。SharePointは電力と冷却の点では悪夢だった。マーケティングや販売活動の促進という面ではそれほど高価ではなかったが、電力、冷却、そしてストレージにかかるコストは結果的に上昇した。仮想化も同じだ。IT部門は仮想化に注意を払い、インフラストラクチャの一部として管理しなければならない。スローダウンして、何をしているかを見極めるということだ」(ミルラッド氏)

調査によると、データセンターの複雑さをコントロールするための試みとして、90%の組織が情報ガバナンスを導入しているか、積極的に話し合っているという。彼らが得ようとしている利点としては、セキュリティの向上、正しい情報を正しいタイミングで容易に取得すること、情報管理とストレージのコスト削減、法的リスクおよびコンプライアンス・リスクの低減、そしてクラウドへの移行が挙げられる。

データセンターの複雑さを軽減するためのベスト・プラクティス

Symantecの別の製品マーケティング担当ディレクターであるトレヴァー・ドウニー(Trevor Daughney)氏は、次のベスト・プラクティスによって、データセンターの複雑さを軽減することを勧めている。

・プラットフォームの向こう側にあるものの可視性を上げる。ITが提供しているビジネス・サービスとそれらの依存関係をすべて理解し、ダウンタイムとコミュニケーション・エラーを減らす。

・所有しているIT資産と、その資産がどのように、また誰に使われているかを理解する。そうすることで、コストとリスクの低減に役立つ。組織は不要なサーバやストレージを購入しなくなり、チームは自分たちが使用するものについての責任を負えるようになり、企業は容量を使い果たしていないことを確認できる。

・復元SLAに適合するためのバックアップ・アプリケーションの数を減らし、資本支出、事業費、トレーニング・コストを削減する。一般的な企業は7つのバックアップ・アプリケーションを持っており、特定のデータベース向けの製品であることが多い。

・情報の急増に対処するため、常に重複排除機能を配備し、データのバックアップに関連するコストの増加を抑える。単にバックアップの重複を排除するのではない。データが大きくなりがちなExchangeやSharePointなどのアプリケーションについては、重複排除機能を持つアーカイブを置くことを検討する。

・バックアップおよび復元操作を容易にするアプライアンスを使用する。

・情報ガバナンスにおいて、経営幹部レベルの当事者意識を確立する。情報について責任を負うという文化を確立し、情報ガバナンスで保護されている状態を作り出せば、組織が取り組んでいるプロジェクト全体で相乗効果を得ることができる。

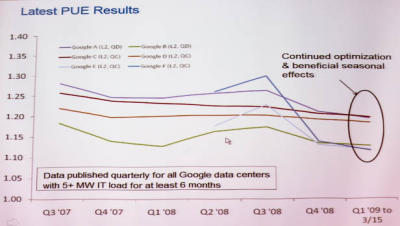

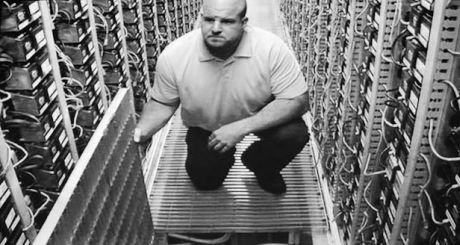

Googleサーバ後部

Googleサーバ後部 効率化されるGoogleデータセンター

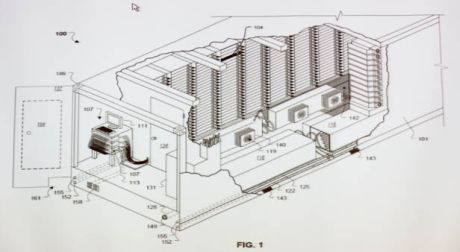

効率化されるGoogleデータセンター Googleのデータセンターコンテナに関するビデオの一場面

Googleのデータセンターコンテナに関するビデオの一場面 Googleのモジュール式データセンター

Googleのモジュール式データセンター

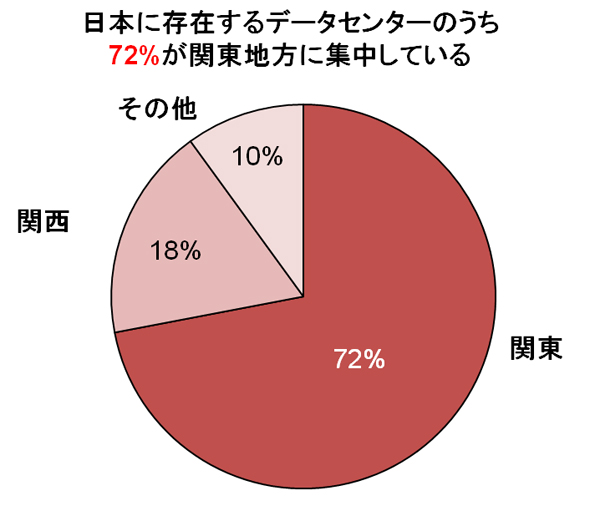

図1 日本のデータセンターは首都圏に集中してしまっている(出典:IDC Japan「データセンターアウトソーシング市場の国内地域別予測」2010年)

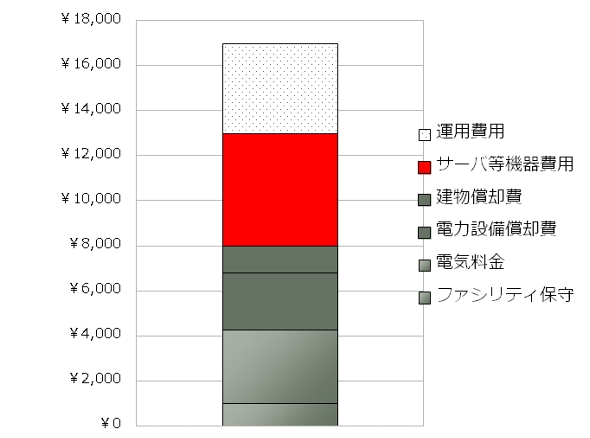

図1 日本のデータセンターは首都圏に集中してしまっている(出典:IDC Japan「データセンターアウトソーシング市場の国内地域別予測」2010年) 図2 日本におけるデータセンター事業者のコスト構造。インテルのクアッドコア・プロセッサを搭載したサーバ1台(消費電力は2200W)にかかる1月当たりの原価を示している。PUE 1.5のデータセンターで試算したもの(出典:オープンガバメントクラウド・コンソーシアム 2010年)

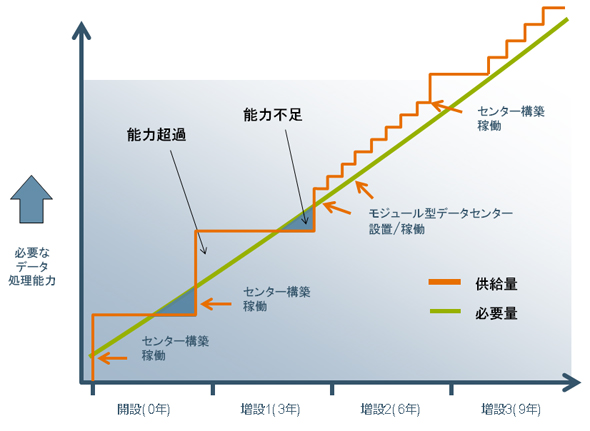

図2 日本におけるデータセンター事業者のコスト構造。インテルのクアッドコア・プロセッサを搭載したサーバ1台(消費電力は2200W)にかかる1月当たりの原価を示している。PUE 1.5のデータセンターで試算したもの(出典:オープンガバメントクラウド・コンソーシアム 2010年) 図3 データセンターの建物を建てるときは、注意して計画を立てないと、需要に応えられるだけのコンピュータリソースを確保できない期間が発生する(出典:オープンガバメントクラウド・コンソーシアム 2010年)

図3 データセンターの建物を建てるときは、注意して計画を立てないと、需要に応えられるだけのコンピュータリソースを確保できない期間が発生する(出典:オープンガバメントクラウド・コンソーシアム 2010年) 図4 建物を設計するときは、サーバでラックを満たせるように設計しなければならない(左)。コンピュータ技術が進化するスピードを見誤ると、建物が完成してもラックに十分な電力を供給できず、ラックをサーバで満たせないということが発生しうる(右)(出典:オープンガバメントクラウド・コンソーシアム 2010年)

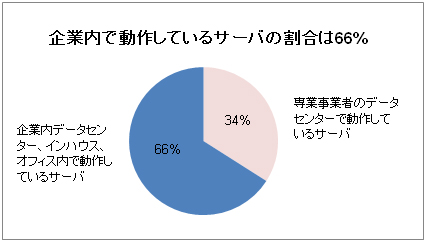

図4 建物を設計するときは、サーバでラックを満たせるように設計しなければならない(左)。コンピュータ技術が進化するスピードを見誤ると、建物が完成してもラックに十分な電力を供給できず、ラックをサーバで満たせないということが発生しうる(右)(出典:オープンガバメントクラウド・コンソーシアム 2010年) 図1 図1 日本におけるデータセンター利用率。自社でサーバを抱え込んでいる企業が多く、半数以上のサーバが企業が自社で抱えるデータセンター、企業内サーバルーム(インハウス)、オフィスで動作している(出典:IDC Japan)

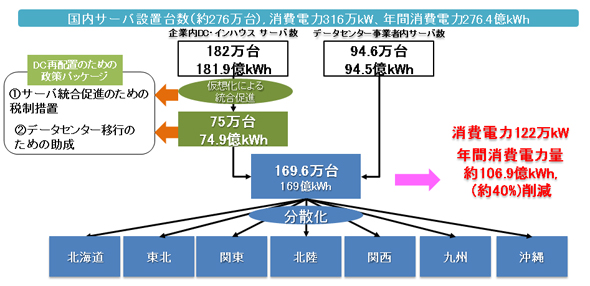

図1 図1 日本におけるデータセンター利用率。自社でサーバを抱え込んでいる企業が多く、半数以上のサーバが企業が自社で抱えるデータセンター、企業内サーバルーム(インハウス)、オフィスで動作している(出典:IDC Japan) 図2 日本中のサーバをデータセンターに集約することで期待できる消費電力節減効果(出典:アクセンチュア)

図2 日本中のサーバをデータセンターに集約することで期待できる消費電力節減効果(出典:アクセンチュア)